全面探讨分布式系统构建基础理论及其典型场景下的问题处置方法

- 问答

- 2025-09-19 01:51:34

- 1

一场永不停歇的「修修补补」游戏

分布式系统这东西,乍一听挺高大上,什么「高可用」「一致性」「容错」,一堆术语砸过来,搞得好像不搞点微服务、K8s都不好意思说自己是程序员,但真上手了才发现,这玩意儿就是个大型「打地鼠」现场——一个问题刚摁下去,另一个又冒出来 😅。

理论基础?先别急着背CAP

很多人一上来就背CAP定理(一致性Consistency、可用性Availability、分区容错性Partition tolerance),仿佛这是分布式系统的「圣经」,但说实话,CAP更像是个「免责声明」——告诉你「鱼与熊掌不可兼得」,但没告诉你「怎么选鱼还是熊掌」。

你做个电商库存系统,一致性必须拉满(不然超卖就GG了),这时候就得牺牲点可用性(比如下单时短暂卡顿),但如果你做的是社交动态,稍微延迟几秒看到新消息?用户骂两句也就过去了,可用性优先。

个人踩坑案例:之前做的一个实时聊天系统,一开始死磕强一致性,结果高峰期疯狂超时,用户直接炸锅,后来改成最终一致性+客户端本地缓存,世界瞬间清净了……(果然,用户要的是「能用」,不是「理论完美」)

典型问题:你以为的「分布式」VS 实际的「分布式」

1 网络:最不可靠的「可靠」组件

分布式系统的核心问题,90%可以归结为「网络抽风」,你以为RPC调用是「A→B」?不,现实是「A→(丢包)→(重试)→(超时)→(B其实收到了但A不知道)→(重复请求)→(B崩溃)」🤯。

解决方案?

- 超时+重试:但别傻傻无限重试,小心雪崩。

- 幂等设计:让B能淡定处理重复请求(比如用唯一ID去重)。

- 熔断降级:B顶不住时,A赶紧自己玩自己的,别死等。

2 数据一致性:从「绝对正确」到「勉强能跑」

强一致性(如Paxos、Raft)适合金融场景,但写性能感人;最终一致性(如CRDT、事件溯源)更「佛系」,适合社交、IoT。

个人见解:大多数业务根本不需要强一致,只是工程师的「强迫症」作祟,比如用户点赞数,晚几秒同步会死吗?不会,但代码里非要加分布式锁,结果把自己锁死了……🔒

3 分布式事务:一场「明知不可为而为之」的悲剧

2PC(两阶段提交)?性能拉胯,协调者单点故障,TCC(Try-Confirm-Cancel)?代码写到你怀疑人生,Saga?回滚逻辑能让你半夜惊醒。

现实选择:能不用就不用,尽量拆成本地事务+异步补偿,比如订单系统,先扣库存(本地事务),再发MQ通知物流(异步),失败了就反向操作。

场景实战:别学理论学「骚操作」

1 缓存穿透:当「查无此数据」变成性能杀手

经典问题:黑客疯狂请求不存在的ID,绕过缓存直击DB。

解决方案:

- 布隆过滤器(Bloom Filter)挡一波。

- 缓存空值(

key-not-found: true),但别设太久,不然内存爆炸。

2 脑裂问题:当ZK/ETCD「精神分裂」了

集群网络分区后,两边都觉得自己是老大,同时写数据,直接裂开。

应对策略:

- 用Quorum机制(多数派投票)。

- 加「fencing token」(类似版本号),旧leader的请求直接拒绝。

分布式系统没有「银弹」,只有「权衡」

搞分布式系统就像养猫——你以为掌握了所有理论,结果它总能以意想不到的方式打你脸 😼,关键是:

- 别过度设计,够用就行。

- 监控比代码重要,问题往往不是你「设计」出来的,而是「跑」出来的。

- 接受不完美,系统是「活」的,总要修修补补。

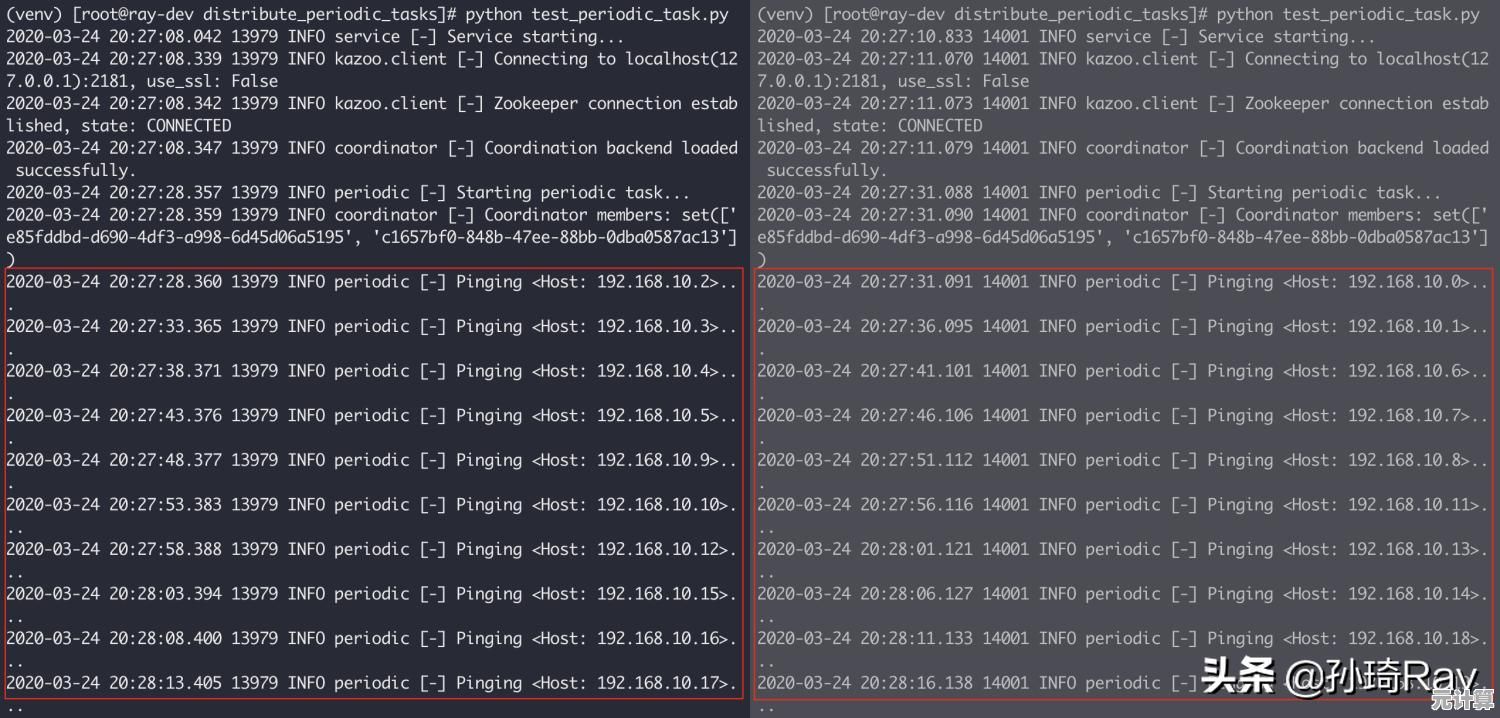

(PS:最近在折腾一个分布式任务调度系统,光是「任务重复执行」就让我掉了三根头发……有没有同病相怜的?🙃)

本文由海姝好于2025-09-19发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:http://max.xlisi.cn/wenda/29636.html