分布式系统在云原生环境中的架构变革及稳定性挑战探究

- 问答

- 2025-09-29 20:56:32

- 3

分布式系统在云原生里的“变形记”与“生存焦虑”

记得第一次把那个笨重的单体应用拆成微服务塞进K8s集群时,我们团队简直像打了胜仗——直到凌晨三点被刺耳的告警电话惊醒,屏幕上跳动的红色线条不是优雅的微服务拓扑图,而是一团乱麻,那一刻我忽然明白:云原生不是分布式系统的终点,而是另一场更复杂冒险的开始,我们以为拥抱了弹性与敏捷,却一脚踏进了混沌的深水区。

架构变形记:从“搭积木”到“养生态”

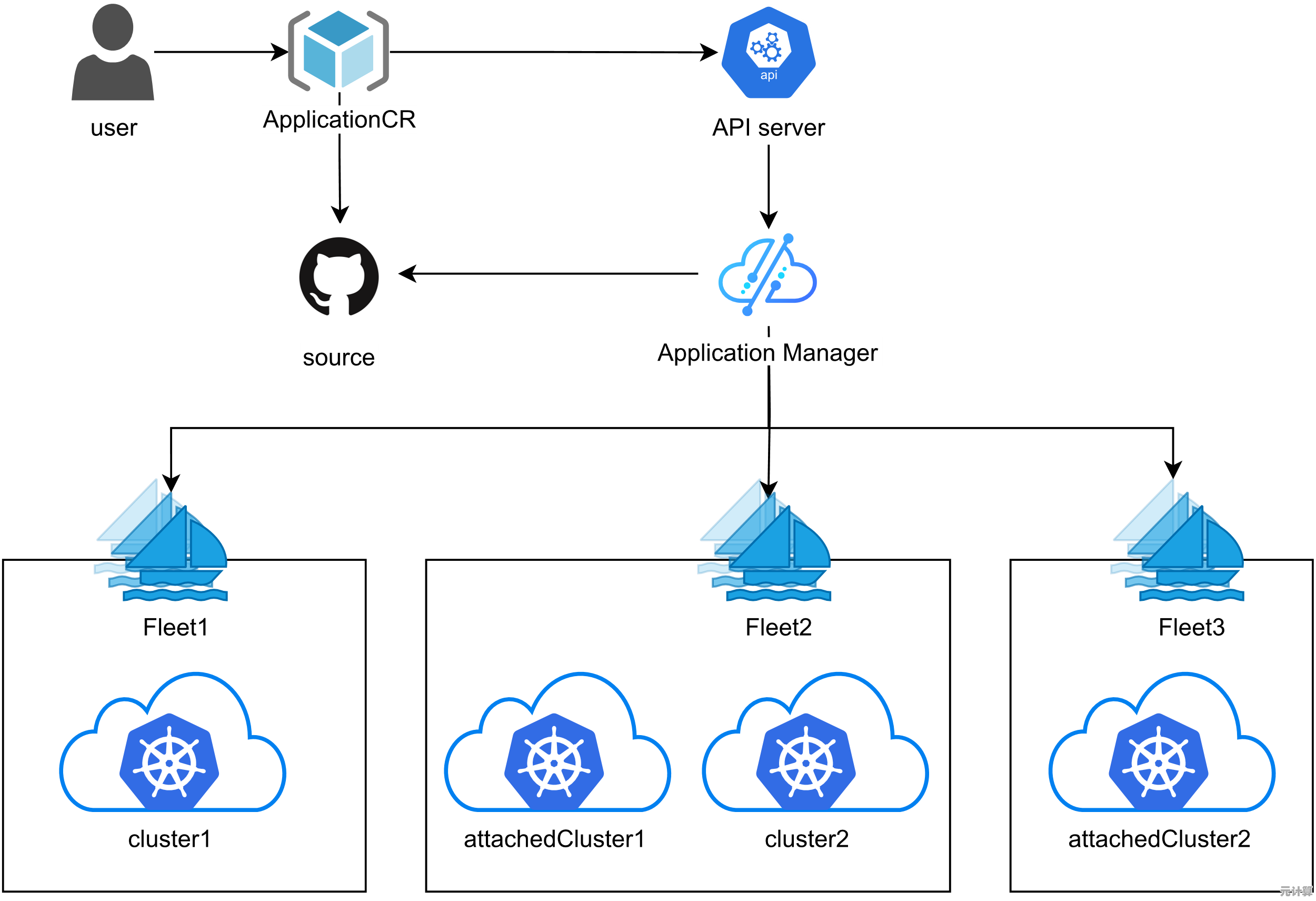

以前搞分布式,像在搭积木:虚拟机是底座,服务是模块,网络是胶水,拼得再精巧,底座一抖,全盘皆输,云原生来了,积木变成了活细胞——容器是基础单元,K8s是那个神秘的“生命维持系统”,服务网格(Service Mesh)则像突然长出的神经末梢。

- “拆”得越碎,世界越复杂: 微服务拆解了功能,也拆碎了故障域,那次因为一个边缘节点上的Redis实例内存泄漏,竟连锁触发了整个订单服务的雪崩,Istio的熔断器(Circuit Breaker)配置?我们自以为懂了,结果一个过于激进的超时设置,让正常流量也被误杀,故障像病毒,在细密的服务网格里传播得悄无声息,我们盯着监控面板上那些代表“健康”的绿色小点,却不知道哪一颗下一秒就会变红——这种无处不在的“未知”让人焦虑。

- Serverless:甜蜜的“失控”陷阱? Lambda函数写起来真爽,不用管服务器,按需付费,直到那个依赖第三方API的订单处理函数,因为上游一个未预期的响应格式变更,默默丢掉了上百个订单,没有日志?有,但散落在CloudWatch的茫茫大海里,排查像在黑暗森林里找一根特定的针,Serverless承诺的“无运维”更像一种幻觉——运维的形态变了,从管机器变成了管事件流、管冷启动、管那该死的全局状态一致性(或者压根放弃一致性?)。

- 配置:藏在YAML文件里的“地雷阵”: K8s的声明式API很美,直到你发现一个错位的缩进,或者一个本该是

ClusterIP却写成NodePort的服务定义,让内部数据库直接暴露在公网上,我们花了整整一个周末,才从海量的Helm Chart和Kustomize overlay里揪出那个捣蛋的配置项,云原生把基础设施也代码化了,但调试这些“代码”的痛苦,比写业务逻辑还甚,每次kubectl apply都像在拆弹,手心里全是汗。

稳定性挑战:在“流沙”上盖高楼

云原生的弹性是双刃剑,资源能自动伸缩了,但故障模式也指数级复杂了。

- 网络:从“高速公路”到“热带雨林”: 在虚拟机时代,网络问题相对“粗犷”——断就断了,目标明确,在K8s的Overlay网络(Calico、Flannel)里,问题变得“精致”而诡异,那次两个Pod明明在同一个Node上,

ping得通,HTTP请求却神秘超时,最后揪出是Node上的某个iptables规则被一个“聪明”的运维脚本意外篡改,Service Mesh(如Istio)引入的mTLS加密,又带来了新的性能瓶颈和证书管理噩梦,网络不再是管道,而是一个充满未知生物的生态系统。 - 可观测性:从“X光片”到“核磁共振”,但你看得懂吗? Prometheus+Grafana+Jaeger+Loki 全家桶堆起来了,数据多到爆炸,但那次支付服务延迟飙升,我们对着密密麻麻的指标和链路图,像看天书,是数据库慢?是某个下游API卡了?还是服务网格的Sidecar在作祟?指标太多,关联性太弱,根因分析(RCA)成了玄学,工具给了我们“核磁共振”的能力,但解读影像仍需老中医般的经验和直觉——而这恰恰是新团队最缺的,我曾盯着一个诡异的99分位延迟毛刺整整两天,咖啡喝到心悸,最后发现是垃圾回收(GC)的一次偶然STW(Stop-The-World)撞上了流量小高峰,这种“偶然”在分布式系统里就是必然。

- “依赖地狱”的终极形态: 你的服务依赖A,A依赖B,B又调用了云厂商的一个托管服务C,当C因为一个区域性的故障(比如某次著名的云存储服务中断)而不可用时,你的服务即使本身健壮如牛,也只能跟着“躺平”,更可怕的是,C的故障模式可能完全超出你的认知和控制范围,这种深度耦合的、跨边界的依赖,让“高可用”设计变得像在流沙上盖楼,我们精心设计的重试、降级、超时策略,在云服务商一个长达数小时的全球性故障面前,显得如此苍白无力,那种深深的无力感,比代码写不出更让人沮丧。

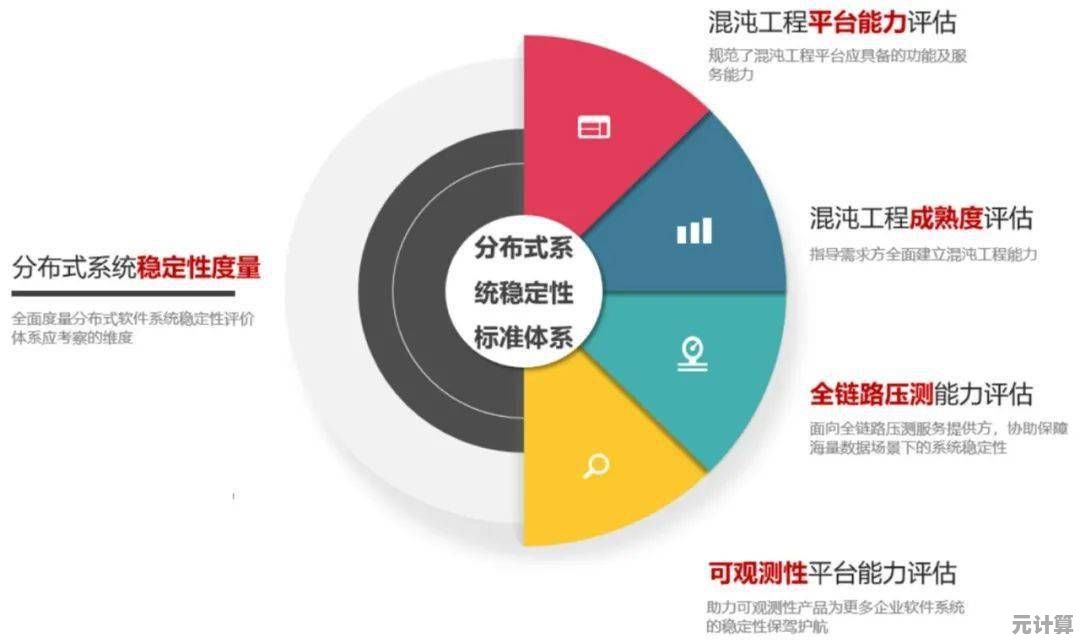

求生之道:拥抱混沌,驯服未知

在云原生的分布式世界里,追求“永不宕机”是奢望,我们开始学着与“失败”共舞:

- 混沌工程不是“作死”,是“疫苗”: 我们硬着头皮在生产环境的“金丝雀”集群里跑Chaos Mesh,第一次故意杀掉一个核心服务的50% Pod时,整个作战室鸦雀无声,手心冒汗,结果?真的发现了Hystrix线程池配置不合理,导致连锁失败,主动注入的“小病”,避免了未来的“猝死”,这需要勇气,更需要一套严谨的熔断机制和快速回滚预案。

- “韧性”比“强壮”更重要: 不再死磕“零故障”,而是设计“优雅降级”,当推荐引擎超时,前端直接展示静态热门榜单;当积分服务不可用,先允许下单,事后再补偿,接受部分功能的暂时不可用,保住核心业务流,这需要产品、开发和运维的深度协同,打破部门墙。

- 可观测性要“做减法”: 不再盲目追求收集所有指标,我们开始定义清晰的SLO(Service Level Objective),订单创建API的99分位延迟<500ms”,围绕SLO构建监控和告警,当仪表盘上只高亮显示几个关键黄金指标(Golden Signals)——延迟、流量、错误率、饱和度时,值班同学的眼睛终于不用再被信息淹没了,工具是手段,而非目的。

- 敬畏“配置即代码”: 像对待核心业务代码一样对待K8s YAML、Helm Chart、Terraform脚本,严格的Code Review,版本控制,甚至引入OPA(Open Policy Agent)做配置策略检查,把“人肉运维”的随意性,关进自动化、规范化的笼子里,一次血的教训让我们明白:一个错误的

kubectl apply,真的能让整个系统瞬间瘫痪。

在流动的云上,寻找确定性的锚点

云原生下的分布式系统,像一片生机勃勃又危机四伏的热带雨林,它不再是我们精心设计的静态模型,而是一个持续进化、充满意外的复杂适应系统,那些教科书里完美的CAP理论、一致性算法,在每秒自动扩缩的Pod、漂移的IP、波动的网络延迟面前,常常显得力不从心。

我们追求的稳定性,不再是坚不可摧的堡垒,而更像在惊涛骇浪中保持航向的船,它需要的不只是技术栈的升级,更是思维模式的转变——拥抱不确定性,设计韧性,在混沌中建立秩序,每一次深夜的故障复盘,每一次对“优雅失败”的设计讨论,每一次在混沌实验中屏住的呼吸,都是我们在这片“云上雨林”里艰难求生的印记,这条路没有终点,但每一次从故障中爬起,都让我们对这片“混沌之地”多了一分敬畏与掌控。

下次当你kubectl get pods看到一片健康的Running状态时,不妨问问自己:这平静的表面下,又藏着多少我们尚未察觉的暗流?

本文由广飞槐于2025-09-29发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:http://max.xlisi.cn/wenda/44883.html