高分辨率图像处理技术深度解析:原理探索与实际应用指南

- 问答

- 2025-10-01 09:24:19

- 2

从像素到现实,我的探索与踩坑笔记

记得第一次接触高分辨率图像处理,是因为一个项目需求——客户丢来一批8K航拍影像,问我“能不能把地面车牌号还原出来”,我当时的反应是:“这玩意儿真的不是科幻片素材吗?”🤯 结果折腾了整整两周,电脑风扇嗡嗡作响,我才意识到高分辨率处理根本不是“放大一下”那么简单。

高分辨率技术的核心:不只是“更多像素”

很多人觉得高分辨率就是堆像素,但真正的问题在于:像素多了,信息密度反而可能下降,比如一张4K图像和一张1080p图像,如果传感器尺寸相同,单个像素的进光量其实更少,噪点更明显(这叫“像素串扰”,我一开始完全没料到)。

超分辨率的本质是“猜”——用算法补全缺失的细节,比如经典的SRCNN(超分辨率卷积神经网络),其实是在学习低分辨率到高分辨率的映射关系,但这里有个坑:如果训练数据不够多样,模型容易“脑补过度”,有一次我用建筑效果图训练模型,结果它把树叶全还原成了马赛克风格的绿疙瘩……🌿(后来发现是因为训练集里太多重复纹理)。

实际应用中的“翻车”与惊喜

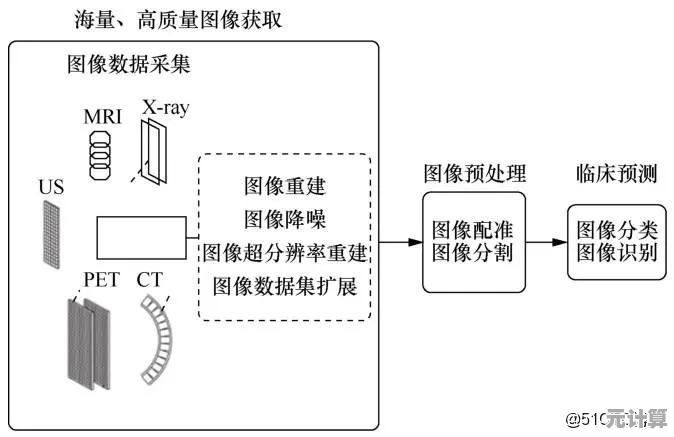

案例1:医疗影像中的血管增强

曾经帮一家医院处理视网膜图像,目标是凸显细微血管,传统插值放大后血管边缘糊成一片,后来改用GAN(生成对抗网络),让生成器和判别器“互相博弈”,结果模型确实学会了增强细节,但偶尔会把噪点误判为血管——医生吐槽说“你这AI比实习生还能瞎编”😅,最终解决方案是结合形态学处理手动修正,才达到可用状态。

案例2:老旧影片修复

朋友工作室接了个老电影修复项目,原片布满划痕和噪点,我们试了基于光流法的帧间补偿,但快速运动场景直接崩了……最后是混合了非局部均值去噪+时序一致性约束才勉强搞定。高分辨率处理最怕的就是“静态好用,动态翻车”,这点在视频领域尤其明显。

个人踩坑心得(非专业建议版)

- 硬件是爹,优化是妈:没显卡别玩高分辨率模型,我曾经用CPU跑ESPCN(轻量级超分模型),一张图等了半小时,期间喝了三杯咖啡☕️。

- 数据质量>算法复杂度:拿手机拍的模糊照片想还原出细节?醒醒,除非你是FBI技术组👮♂️,噪声太多的低分辨率图,再牛的算法也救不了。

- 边缘细节是玄学:至今没找到完美处理毛发、水流、火焰这类非刚性边缘的方法,有时候手动涂几笔PS比AI跑一天更自然……(求别喷,这是真实血泪史)

效率与真实的博弈

现在很多手机厂商宣传“AI亿级像素”,其实多半是多帧合成+算法锐化,真正的单张超分辨率依然很难——毕竟物理限制摆在那儿,我个人更期待神经辐射场(NeRF)这类技术,用少量图片生成3D细节,比纯2D拉伸更有潜力🎯。

不过话说回来,技术再强也得看需求,上次有个客户问:“能不能把这张100×100的logo放大到户外广告牌尺寸还不糊?”我沉默了一会,回他:“不如我们重新设计一个?”🙏

本文由冠烨华于2025-10-01发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:http://max.xlisi.cn/wenda/47187.html